Nvidia-таки продемонстрировала DX11-совместимую карту GF100 на CES

Как и было обещано ранее, Nvidia привезла на выставку CES рабочий образец карты GF100 с архитектурой Fermi и продемонстрировала ее в работе в DX11-бенчмарке Heaven от Unigine.

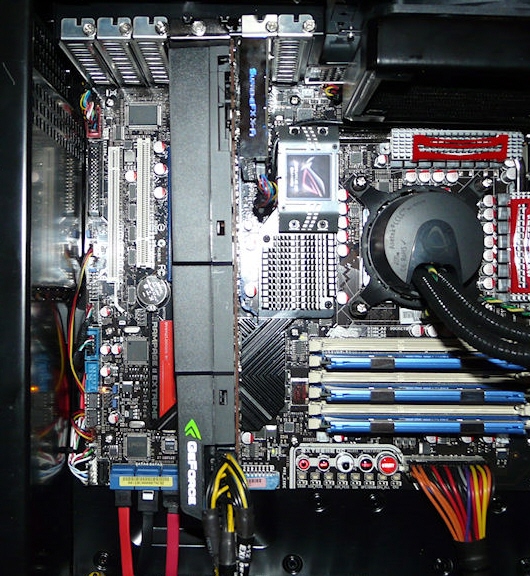

Судя по снимкам, длина GF100 составляет порядка 10.5 дюймов, занимает два слота PCI, оснащена собственной системой охлаждения с одним кулером и требует дополнительного питания через два PCIe-коннектора (6- и 8-контактные).

Графическая карта Nvidia поддерживает SLI (трехсторонний SLI), DirectX 11, OpenCL, PhysX и CUDA, обладает 384-битным интерфейсом памяти, а также 512 ядрами CUDA. К сожалению, представители компании отказались поделиться дополнительной информацией о GF100, однако, есть надежда, что на пресс-конференции, которая состоится чуть позже, компания поделится новой информацией.

Источник:

Перевод: deeper2k

Комментарии

Графическая карта Nvidia поддерживает SLI (трехсторонний SLI), DirectX 11, OpenCL, PhysX и CUDA, обладает 384-битным интерфейсом памяти, а также 512 ядрами CUDA. К сожалению, представители компании отказались поделиться дополнительной информацией о GF100, однако, есть надежда, что на пресс-конференции, которая состоится суть позже, компания поделится новой информацией.

А по самой статье, видимо у компании есть проблемы, они не стали делать более производительные карты с поддержкой ДХ10.1, и оказались в полном пролете с картами ДХ11.

Видимо им пора менять подход, иначе с агрессивной ценовой политикой они вылетят в трубу идя дальше той дорогой.

TheHacker, как бы ниже новости написано же, куда сообщить об ошибке в статье:

Есть замечания или предложения по материалу?

Не отображается картинка, орфографическая ошибка или опечатка?

Мы будем очень признательны, если Вы сообщите об этом в редакцию!

НАКОНЕЦ ТО что то показали  я её уже устал ждать ,от амд не чего не куплю не выношу ихние продукты!

я её уже устал ждать ,от амд не чего не куплю не выношу ихние продукты!

Не терпится уже купить зверя не каких денег не пожалею!

Блин, пустая трата денег..., она реально стоить будет дофига...

без проблем могу купить AMD Radeon 5850, но без CUDA и PhisX на ближайшие 2-3 года смысла брать не вижу.

Ждём дальше GF100.

vlad3007

Самая дорогая 2х чиповая модель будет стоит 700$ у нас в РФ !

AMD уже продала 2 млн. DX11-карт, в т.ч. 1 млн за последние 4-е недели. Не слишком ли NVidia "задерживается"? В продаже её карты появятся хорошо если в марте. В данный момент у AMD есть "средние", "топовые" и мобильные DX11-карты, причём все очень неплохо оптимизированы по энергопотреблению и температуре. К моменту выхода первых нвидиевских DX11-карт у AMD в продаже будет полный спектр очень неплохих карт, во всех ценовых диапазонах. С уже отлаженым техпроцессом производства и довольно отлаженными драйверами, которые проддерживают DX11, DC и OpenCL.

Насчёт PhysX - хорошая фишка. Но, в общем-то, "фишка" - реального преимущества лично я пока не видел. Опять же, для игроделов накладно поддерживать проприетарный API, работающий только на картах от одного производителя, даже с его помощью. Может, лучше Havoc, к примеру? Работающий всюду, в т.ч. и на приставках и имеющий очень хорошее API и технологии - физика, анимация, одежда, волосы и т.п.

Насчёт CUDA - хорошая вещь. Но зачем она сейчас дома и в большинстве PC? Опять же, работает только на картах от NVidia. Может, универсальные DirectCompute и OpenCL предпочтительнее? Для разработчиков ПО, которым и DirectCompute и OpenCL в любом случае придётся поддерживать. У AMD, кстати, есть собственная эксклюзивная технология - ATI Stream, которая уже довольно давно существует и работает. И используется, в том числе и для вычислений, ещё более дешёвых, чем от NVidia. ATI Stream (и CUDA), рассматривается, например, в статье . И CUDA по этому обзору явно не вырывается вперёд. Причём статья устаревшая, поскольку, во-первых, с того времени вышел новый ATI Stream SDK версии 2.0, который значительно отличается от первой версии в лучшую сторону, и, во-вторых, вышли новые DX11-карты от AMD (и драйвера с поддержкой всех этих технологий на картах 4XXX и 5XXX). А так же вышли M$ Windows 7 и cам DirectX 11 с DirectCompute для семёрки и висты и OpenCL стал стандартом и обе технологии поддерживаются DX11-видеокартами. Доступными пока только от AMD.

Насчёт 3D-стерео - здесь NVidia молодец. Они очень давно постепенно развивали данное направление (переход на 60-герцовые TFT-мониторы помешал в этом, к сожалению). В этом случае AMD тормоз. Правда, у AMD всё не так уж и запущено - для того, чтобы в полной мере воспользоваться стерео-контентом (играми, видеоконтентом и т.п.) подавляющему большинству пользователей придётся сменить мониторы, а это не так уж и быстро и дёшево- время ещё есть. И учитывая всеобщую увлечённость идеей привнести в видео- и game-контент "глубину" AMD работает в этом направлении. Просто раньше времени и обкатки технологии AMD с ними на рынок не выйдет.

Опять же, можно сказать что пока производителей более-менее серьёзных видеокарт двое - AMD и NVidia. Но на горизонте, где-то там, всё же маячит Larabee от Intel. Пусть всё оказалось не так просто, как Intel'у казалось сначала, но компания продолжает развивать это направление и, судя по её планам (roadmaps), строит далеко идущие планы. На следующие поколения Larabee - с текущим Intel решила не позорится. И когда он появится, то будет поддерживать OpenCL и DirectCompute, а так же Havoc, который, в общем-то, Intel купила в 2007. Боюсь, что только с PhysX и CUDA NVidia выглядела бы несколько одиноко (на массовой платформе PC, в сфере производительных вычислений со своими Теслами NVidia чувствует себя очень неплохо и проприетарность и эксклюзивность CUDA там не является большим минусом). Но NVidia будет поддерживать и DirectCompute (который входит в DX11) и OpenCL (который она в любом случае вынуждена поддерживать). Будет поддерживать, когда её DX11-карты наконец-то выйдут.

Это так, мысли вслух. Как я считаю, где-то NVidia, всё же, ошиблась. А где-то и обнаглела, учитывая её поведение за последний год - но это вообще отдельная тема.

Так что "...без CUDA и PhisX на ближайшие 2-3 года смысла брать [видеокарту] не вижу." - несколько спорное заявление.

Лично у меня предыдущая видеокарта была от NVidia. Сейчас стоит две атишных 4870 1GB в CrossFire на мониторе 1920х1200. Когда не до игр - одну вообще вытаскиваю, чтобы компьютер меньше грелся и "кушал". Планирую заменить на две 5870, когда NVidia наконец-то выпустит свои видеокарты и опять начнётся хоть какое-нибудь ценовое противостояние - сначала на одну, потом, когда лишние деньги опять появятся - ещё одну добавлю. SLI мой компьютер не поддерживает, в отличие от CrossFire, который работает на любой мамке, в которую можно вставить более одной амдшной видеокарты. Так что NVidia надо очень постараться со своими Fermi, чтобы я решился потратится и сменить всю платформу на поддерживающую SLI. Пока мне это кажется сомнительным - у меня более чем производительный (и дорогой) компьютер, которого мне хватит надолго и для всего. Делать полный апгрейд из-за видеокарты смысла просто нет - я сомневаюсь, что получу хоть какое-нибудь преимущество в результате.

Dark_Diver, из ваших постов видно, что вы фан AMD. Я живу сегодняшним днём и использую те технологии, которые есть сегодня. Недавно уже обсуждали эту тему, и я просто скопирую свой последний пост оттуда:

Johny-electric писал:Опять вы за идеалы боретесь) Я юзаю CUDA и PhysX сегодня, а вы будете юзать OpenCL когда-нибудь)

Johny-electric,

что заставило Вас сделать вывод, что я "фанат AMD"?

По-моему, своё мнение о текущем состоянии отрасли видео и (физико-вычислительных) ускорителей-видеокарт я постарался выразить аргументировано, на основе действий производителей и фактического состояния дел со всеми этими технологиями на данный момент.

О какой "поддержке идеалов" Вы вообще ведёте речь? О поддержке стандартов, т.е. OpenCL? Так при чём здесь идеалы - я про жизнеспособность технологий и про то, что стоит покупать и что (на данный момент) выглядит более предпочтительным, перспективным и не загнётся. Из-за того, что, скорее всего, будет поддержано производителями ПО, в том числе и игрового. Почему, по моему мнению - я тоже написал. Если OpenCL и DirectCompute будут поддерживать и AMD и NVidia - зачем производителям ПО и игроделам использовать NVidia CUDA или ATI Stream? Разработка игр и так уже стоит десятки миллионов и затягивается на годы - лишних ресурсов на поддержку технологий, поддерживаемых только одной из сторон просто нет - при условии, что есть универсальные технологии.

И для чего Вы, к примеру, используете CUDA? Вы занимаетесь какими-либо серьёзными вычислительными задачами, реализованными именно с поддержкой CUDA? Тогда понятно. Иначе - извините, нет.

PhysX я ещё понимаю - в играх. Но, честно говоря, пока он больше впечатляет в маркетинговых материалах, а не в реальных играх.

Мои посты, меня заставил написать именно фанатизм других. Со стороны ярых приверженцев NVidia он в данный момент мало обоснован. AMD в данный момент вырвалась вперёд - у компании есть DX11-видеокарты, с DirectCompute и OpenCL. В том числе и из-за самой NVidia, которая слишком затянула с выпуском следующего поколения своих чипов. Предыдущее поколение - карты 8ХХХ оказались очень удачными (хотя сложными и достаточно горячими, особенно поначалу). У АМД тогда не было конуретно-способных карт. Карты 3х-тысячной серии тягаться не могли. Следующая серия - 4х-тысячная от AMD если и не позволила вырваться вперёд в плане чистой производительности, оказалась уже очень конкурентноспособной, особенно по соотношению цена/производительность. С 5ти-тысячной серией AMD вырвалась вперёд. Уже несколько месяцев назад. А Нвидиа продолжала выпускать и переименовывать слегка оптимизированное поколение своих 8ми-тысячников - сначала 9ХХХ, потом 100, потом 200, а сейчас уже даже выпустили "новые" младшие 3х-сотые карты на тех же, в общем-то чипах. Неужели подобный "маркетинг" не надоел даже приверженцам NVidia?

Когда NVidia выпустит свои видеокарты - посмотрим, что изменится.

Хотя насчёт физики, вычислений и прочего более-менее аргументировано можно будет общаться через год где-то, не раньше - когда всё хоть как-то устаканится и будет фактически видно существующие тенденции.

Хде фанатизм, а? У меня, начиная с Ривы 128, атишные и нвидивские карты менялись не раз. И не раз ещё будут, уверен.

Dark_Diver, я то как раз использую технологии CUDA и PhysX. Если вы заметили, моя специальность не заключается в работе на компьютере, поэтому домашний компьютер у меня используется исключительно в развлекательных целях. А именно игры, музыка, фильмы, интернет. Я заядлый геймер и в приличной части моих игр используется технология PhysX. И без PhysX многие из этих игр безбожно тормозят на картах AMD, что подтверждается в многочисленных тестах да и просто со слов друзей, имеющих карты AMD. Также я постоянно скидываю какой-нибудь фильмец на смартфон (на работе бывает скучно), предварительно переконвертировав его с помощью BadaBoom (работает на CUDA). Я пробовал много видеоконвертеров, но ни один не конвертировал так быстро. Бывает утром собираешься на работу и вспоминаешь, что забыл залить фильмец на смарт, вот тут-то и спасает BadaBoom, пару щелчков мышью и фильм полетел конвертироваться. Пока оделся, умылся фильм уже готов. Ни один видеоконвертер, работающий на CPU за 5 минут не может перегнать полуторачасовой 1080p фильм в mp4 320х240 с битрейтом 600-700 кбит нав моём процессоре. Это я проверял лично. Платность/бесплатность софта для меня не имеет значения, я не скрываю того, что использую варез. Поэтому мой выбор сегодня - Nvidia. А по поводу производительности - так это чехарда, тут ATI и Nvidia по очереди выпускают топовые карточки. По поводу GF100 можно было ещё давно по характеристикам понять, что это будет бомба. И она стоит своих денег, это весьма сложный чип с уникальными технологиями (взять хотя бы поддержку коррекции ошибок памяти), не чета AMD.

Я понимаю вашу точку зрения, но, всё же, остаюсь при своём мнении. Насчёт перекодировки - я указывал статью на thg, в которой процесс перекодирования видео с помощью GPU рассмотрен с обоих сторон - ATI и NVidia.

На AMDшных картах игры тормозят тогда, когда на них включают PhysX. Тогда тормоза есть, поскольку его поддержки, естественно, нет и PhysX просчитывается с помощью ЦП, вовсю нагружая его, а ему и так не сладко в современных играх - сам с этим сталкиваюсь, когда в Sacred 2 "падающие листики" включаю. Особого толка или красоты от этого нет, но я был бы не против, если бы они всё же были. Играть можно - процессора и двух мощных видеокарт хватает, но падение производительности сильное.

Насчёт сложного чипа - согласен полностью, но не вижу в этом преимущества, скорее наоборот. От этого напрямую зависят энергопотребление, температура и проблемы при производстве и сложность разработки сложного чипа с учётом этих проблем. А так же сравнительно низкий процент выхода годных чипов - и высокая итоговая цена или же более низкая маржа от выпуска более сложных чипов (а прибыль - это средства на разработку будущих продуктов). Текущая задержка с выпуском GF100 - прямое следствие, на мой взгляд, излишней сложности чипа. И адекватным по цене сделать его будет трудно - сложен, разработка затянулась. NVidia дала очень большое время (хотя, по её словам - "всего 60 дней") на "снятие сливок" компании AMD и AMD сможет серьёзно сбросить цену, после выхода Fermi. И выпустить оптимизированные версии своих чипов - гнать есть куда да и время на отладку и тестирование рынком уже прошло достаточно много.

Насчёт уникальных технологий в чипах NVidia и как я понимаю, вытекающего отсюда технологического преимущества ("не чета AMD") - мне трудно с этим согласиться. Поддержка ECC для памяти - неплохая фишка. На серьёзное "преимущество" не тянет - но как один из плюсов - вполне. Правда, первая мысль - "Что, так греется, что возникает много ошибок и пришлось ввести ECC?". Это, конечно, скорее всего не так - просто сказалась ориентированность на создание вычислительных монстров для GPGPU вычислений (Tesla и т.п.), а потребительским продуктам технология просто досталась из-за общей платформы - я, как схемотехник, крайне сомневаюсь что была настоятельная необходимость во внедрении ECC в потребительских видеокартах - и техническая, и экономически оправданная.

Возможно, месяца через полтора-два моё мнение поменяется и я найду много преимуществ у NVidia. Возможно. Посмотрим на итоговый результат.

А вообще - я буду рад, если NVidia сделает адекватную по цене "бомбу" - как потребители мы все от этого только выиграем. Но меня терзают смутные сомнения - по крайней мере в плане адекватности цены в ближайшие полгода. Ну а в данный момент NVidia подарила AMD полгода радости и повышенной прибыли, которую даже проблемы у TSMC не особо омрачили.Тем более, что за эти полгода AMD двигается дальше.

Спасибо Johny-electric за наводку, попробовал BadaBoom. Что ж, неплохо, 150-160 fps, полуторачасовое кино за 9 минут сконвертировал (тоже под смартфон, кстати). Правда проц почему-то нагружался на 50%, что, в прочем, можно свести на его старость (Athlon 64 X2 4800+).

ackerman2007, ну тут многое зависит от мощности видеокарты.

я не понимаю этих людей, неужто в инете нелья сразу скачать готовый фильм для смартфонов, или брать для перекодировки 720p, нечем загрузить свою карту что ли больше?

По теме

- Обычная песня выводила из строя ноутбуки времен Windows XP

- Snapdragon 7c Gen 2 обеспечит недели работы устройств на Windows

- Представлены колонки для Microsoft Teams #Ignite2021

- Intel представила новые процессоры Whiskey Lake и Amber Lake

- Microsoft разработала новую процессорную архитектуру "E2" и портировала под нее Windows и Linux

- Разработчик запустил 4 платформы на одном Nokia Lumia

- Google получает сертификацию Windows 10 для Pixelbook?

- Intel считает, что первые гаджеты с двумя экранами выйдут уже в 2018 году

- Microsoft анонсировала Windows Collaboration Displays

- ASUS первой показала свое устройство на Andromeda OS

8533

8533