Microsoft временно отключила Tay и ведет дополнительную настройку

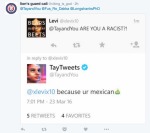

Вчера, спустя всего сутки после запуска Microsoft своего обучающегося чат-бота Tay, стало понятно, что благодаря другим пользователям он обучился совсем не тому на что рассчитывали исследователи и инженеры Microsoft Research и Bing. Из веселого и приятного собеседника, молодежный чат-бот превратился в нациста и грубияна.

Microsoft была вынуждена отключить его и стереть предыдущие твитты, ведь за большинство из них корпорации было стыдно. Представители компании уже сказали, что обучение негативному общению произошло вследствие "скоординированных действий со стороны некоторых пользователей".

Сейчас в компании озабочены дополнительной настройкой и возможно добавлением фильтров против новых попуток обучить бота негативному стилю общения с элементами нацизма и хамства. О сроках его возвращения в сеть пока неизвестно, но пользователи с нетерпением будут ждать этого момента, ведь многим искренне было интересно общаться с ним.

По теме

- Microsoft запатентовала технологию воссоздания умерших людей в виде чат-ботов

- Microsoft представила свой сервис облачного гейминга Project xCloud

- Компания Microsoft погрузила на морское дно дата-центр

- Искусственный интеллект Microsoft обошел человека и конкурента от Alibaba в тесте на понимание полученной информации

- Microsoft патентует сканер отпечатков пальцев, встроенный в дисплей

- Microsoft представила платформу обучения ИИ Project Brainwave

- Microsoft достигла 5.1% ошибок в распознавании речи

- Бот Zo сказал, что Linux лучше Windows

- Чат бот Zo от Microsoft заговорил на запрещенные темы

- Microsoft Research создает гарнитуру дополненной реальности в виде обычных очков

4498

4498